人文情報学月報第101号

ISSN 2189-1621 / 2011年8月27日創刊

目次

- 《巻頭言》「『水原抄』から「くずし字認識」まで」

:ROIS-DS人文学オープンデータ共同利用センター/国立情報学研究所 - 《連載》「Digital Japanese Studies 寸見」第57回

「CSS Writing Modes Level 3が正式勧告」

:国文学研究資料館古典籍共同研究事業センター - 《連載》「欧州・中東デジタル・ヒューマニティーズ動向」第19回

「Universal Dependencies: 依存文法ツリーバンクの世界標準」

:ゲッティンゲン大学 - 人文情報学イベント関連カレンダー

- イベントレポート「DADH2019学会参加報告書」

:北海道大学大学院文学院/日本学術振興会 - 編集後記

《巻頭言》「『水原抄』から「くずし字認識」まで」

2019年10月14日、Kaggle Kuzushiji Recognition Competition が無事に終了し、機械学習分野の参加者は数百人にのぼりました。12月11日には Google 六本木ヒルズオフィスにて開催された Kaggle Days Tokyo イベントでホストとしてコンペティション実施報告をしました。このコンペティションの成果は将来、くずし字認識の研究に大いに貢献することでしょう。

くずし字認識は日本古典籍と機械学習という二つの分野のディシプリンを必要とする研究ですが、そもそもなぜ筆者のような国文学研究者がこの研究を始めようとしたのかについてお話しします。

筆者は早稲田大学大学院文学研究科で『源氏物語』の古注釈を研究してきました。古注釈と言っても、専門は鎌倉時代から南北朝時代までの古注釈です。筆者の研究は鎌倉時代の源氏学者の一人である源親行を中心としたものでした。親行と彼の父親である光行は鎌倉時代の河内守であったため、彼らの校合した『源氏物語』の写本は「河内本源氏物語」と呼ばれ、現代まで伝わってきました。この河内守の作成した『源氏物語』古注釈は『水原抄』と呼ばれています。

『水原抄』の名はどの時代の『源氏物語』研究者でもよく知られていますが、室町時代あたりから、誰も伝本を確認できない状態になり、幻の本になってしまいました。『水原抄』の内容は現存している注釈書にみられるいくつかの逸文しか知られていないのです。筆者の大学院生時代の研究はこの『水原抄』の逸文を探し続けることでした。逸文探しですから、翻刻された古注釈だけでは内容が足りず、博士論文を仕上げる段階で最後に調査した資料は東山御文庫蔵『七毫源氏』という『源氏物語』の写本でした。

『七毫源氏』は京都、東山御文庫の所蔵であり実物を調査することはできないのですが、宮内庁書陵部でマイクロフィルムが見られます。現存している『七毫源氏』は『源氏物語』54帖のうち、44冊しかありません。それでも、調査するたびに書陵部に行って、一枚一枚の画像を見て情報をまとめるのは、とても大変な作業でした。そのとき、「この写本を検索できればいいのに」と考え始めたのです。

全文検索はテキストがあれば、Ctrl+F を押すだけで簡単にできますが、翻刻されていない写本はどうやってテキストを取り出すのでしょうか。そこに OCR(Optical Character Recognition、光学文字認識)の技術が登場します。筆者は2017年1月ごろに OCR 技術について調べ始めて、機械学習にたどり着いたのです。そこで Kaggle の名前も初めて知りました。最初に参加した Kaggle コンペは2017年5月に開催された「Zillow Prize: Zillow’s Home Value Prediction (Zestimate)」でした。

『源氏物語』古注釈からいきなり機械学習に取り組むことになぜ抵抗がなかったかというと、それは筆者の経歴に理由があります。小学2年生からパソコンを触り始め、小学5年生からプログラミングを勉強し始めて、高校まで勉強も理系ルートで複数のプログラミングコンテストに参加し、受賞もしましたが、大学ではコンピュータサイエンスを選択せず、日本語教育を専攻し、プログラミングはアルバイトだけにしました。日本語教育専攻を選んだおかげで、日本政府文部科学省の国費留学生になり、早稲田大学大学院文学研究科の陣野英則先生の研究室に進学ができました。早稲田にいた10年間、プログラミングには一切触れませんでしたが、くずし字の OCR の研究を考え始めたときには、「無理」というより「やってみないとわからない」と思っていました。

機械学習を研究するにはまず高性能な計算機が必要で、文学研究科の環境ではなかなかできないため、自分と同じタイ人国費留学生である親友の指導教員、東京大学大学院総合文化研究科のコンピュータグラフィックス、画像処理専門の山口泰先生に手紙を書きました。その手紙で自分の研究事情を説明し、ありがたいことに、山口先生は研究室に受け入れてくださいました。さらに2017年には大学院学生交流連合(早稲田大学・京都大学・慶應義塾大学・東京大学)派遣学生プログラムにより、筆者は早稲田大学の学籍を持ちながら、東京大学でも正式に特別交流学生になれました。そして2017年9月から東大山口研で本格的にくずし字認識の研究を開始し、2018年4月から人文学オープンデータ共同利用センター、国立情報学研究所に就職しました。

くずし字認識モデル開発は2018年8月ごろに開始し、最初のプロトタイプモデルは NekoNet(Neural End-to-end Kuzushiji OCR)でした。NekoNet の論文は北本朝展部先生をはじめとして、指導・協力してくださった方々のおかげでその年の12月の情報処理学会人文科学とコンピュータシンポジウムにて最優秀論文賞を受賞しました。その後、NekoNet は大幅に改良され KuroNet モデルになりました。KuroNet の論文[1]は2019年2月に The International Conference on Document Analysis and Recognition(ICDAR)に投稿し、9月にシドニーで発表しました。そして、2019年11月に KuroNet サービスを一般公開しました。

Kaggle くずし字認識コンペティションの開催は2019年2月に決まり、7月に開催したので、準備には約5ヶ月かかったことになります。コンペティションデザインはすべて KuroNet をベースにし、KuroNet はこのコンペのベースラインモデルとして大活躍してくれました。

筆者のくずし字認識研究の経緯はこのようなものでした。この過程において筆者にチャンスを与えてくださった、早稲田大学の陣野英則先生、東京大学の山口泰先生、そして国立情報学研究所の北本朝展先生には深く感謝しております。また、くずし字認識モデル KuroNet の成功は筆者だけの成果ではありません。筆者の共同研究者であるモントリオール大学の Mila 学習アルゴリズム研究所の Alex Lamb さんとケンブリッジ大学学部1年生18歳の天才 Kaggle Grandmaster の Mikel Bober-Irizar の協力が不可欠で、大いに感謝しています。くずし字認識の研究には課題がまだ多くありますが、これからも研究を頑張って、いつか古典籍の検索機能を実現したいと思っています。

執筆者プロフィール

《連載》「Digital Japanese Studies 寸見」第57回

「CSS Writing Modes Level 3が正式勧告」

W3C(World Wide Web Consortium)は、CSS3の一部として、2019年12月10日に CSS Writing Modes Level 3を正式な勧告として公開した[1][2]。CSS はウェブページのレイアウトを記述する言語であるが(EPUB などでは印刷媒体制御も行う)、このモジュールは、とくに書字方向についての規格を定めるもので、はじめて CSS として正式に縦書きに対応したものとして注目を集めている[3]。

このモジュールは、公式にはCSS2(CSS Level 2)にある unicode-bidi および direction プロパティの置き換えを企図したものであるため Level 3を称しているが[4]、実質的には、Microsoft が2000年に提案し、Internet Explorer 5.5で先行実装された(日本語市場をターゲットにした)writing-mode プロパティを、世界的な目から公式に策定するものといえよう[5]。なお、付言すれば、正式決定にこれだけかかったことから想像できるように、IE5.5における writing-mode プロパティと現在のプロパティに互換性はない。この内容の CSS3内での位置づけも、多くの変動を経ている。CSS 内部におけるテキスト処理・配置を議論するモジュールに最初に現れたものが分割され[6]、2010年に最初のワーキング・ドラフトが出た[7]。2014年に勧告候補となっていたが[8]、CSS3における安定した仕様を示す CSS Snapshot には2017年版にまで出てきていなかったなど[9]、のちにも触れるが、横書き以外の環境に対する経済的関心のとぼしさや、そもそもの計算モデルの問題などもあって、ブラウザの実装や議論がなかなか進まなかったものが、このたびようやく日の目を見るに至ったといえる。

内容としては[10]、最初に述べたように書字方向に関する記述に特化したものである。書字方向とは文字を書く方向のことで、日本では縦書き・横書きがあるが、世界の書字方向は実に多彩で、歴史時代にまで遡れば一方向とはかぎらず、牛耕式とも呼ばれる都度向きの変わる文字体系も存する(すくなくとも writing-mode では実現されていない)。エジプト文字のように向きが自由な文字もあれば、モンゴル文字のように縦書きながら左から右に行を書き進めるものもあって、また、ブラウザで利用するにはそれらが混在する場面も想定しなければならないため、どうしても複雑な検討を要することになる。たとえば、アラビア文字は横書き専用の文字であるが、ローマン・アルファベットなどとちがって右から左に書き進める。ローマン・アルファベット主体の表記のなかにアラビア文字が来たばあい、あるいはその逆のばあい、どのように表示するかはかなり難しい調整を要する(ひどい実装だと、アラビア文字が文中の場所と関係なく右端に寄ってしまうこともある;そうでなくともカーソルの動き方は複雑になる)。既存の CSS の体系でアラビア文字のような逆向きの方向を制御していたのが unicode-bidi や direction プロパティであって、最初の部分はそれに関する整理が行われている。中間の前半では縦書きに関する議論で、writing-mode がその中核にある。Internet Explorer 5.5における実装は、W3C における公式の規格ではないため、議論がされていないが、それを参照した別の公式の規格があるため、それらとの違いが議論されている。中間の後半部はいわゆる混植の調整に関する議論に割かれている。これは、「日本語組版処理の要件」[11]という文書をふまえて世界的に文字体系の配置処理(組版処理)に必要な技術要件を検討したものに多くを負っていて[12]、文字をどのように行として揃えるかなどの混植ゆえに発生する(とはいえマイナーな)問題を実装が複雑になりすぎない範囲で議論している。最後の部分では、CSS の描画モデルについて議論されている。文字配置は、文字を描画する領域を確保し、そこにどのように文字を配列していくか決定する作業であるから、その計算を厳密に定義しないと破綻(文字が重なるなど)を招きやすい。そのような計算モデルが十分に定義されていると、安心してブラウザが実装できるようにもなるわけである。

ただし、CSS では、仕様として策定されて公開されることと、ブラウザが実装することとはかならずしも関係しない。writing-mode プロパティについてみれば、Mozilla Firefox では2015年12月の Firefox 43から、Google Chrome では2016年1月の Chrome 48から、Internet Explorer では、現行の仕様にあわせた実装は9から対応となっており[13]、どのブラウザも部分的に未実装の内容を残している点でまだまだ利用には課題も多い[14]。また、本モジュールはあくまで書記方向を指定するものであるので、こまかなテキスト配置の細部は、CSS Text モジュール Level 3の確定などを待たねばならないところであるし[15]、ルビについてはそちらのモジュールがある[16]。文字方向についても、Unicode での文字情報に依存しているところがあり[17]、これでおしまいではからきしないのである。じっさい、Level 3で策定をあきらめたものを含めてすでにLevel 4が予定されているところである[18]。

日本語でも縦書きは衰退傾向にはあり[19]、それにはウェブでの非対応もあったのだろうが、縦書き Web 普及委員会[20]のような活動もあまり知られてはいないところである。とはいえ、日本語は縦書きの時代が長く、歴史文書の適切な取り扱いには縦書きへの対応は必須であり、デジタル人文学にとって、この正式対応が遅きに失したものでないことを祈るばかりである。

“World Wide Web Consortium (W3C) puts a stake in the ground for international writing modes,” https://www.w3.org/2019/12/pressrelease-css-writing-modes-rec.html.en

なお、プロパティとは、CSS が表示を制御する任意の部分における属性(フォントサイズなど)を意味する。

“fantasai 51: CSS WG – Modularization,” http://fantasai.inkedblade.net/weblog/2011/inside-csswg/modules および “CSS current work & how to participate,” https://www.w3.org/Style/CSS/specs 参照。

ここで出てくる International Layout モジュールは1999年9月10日のワーキング・ドラフトを最後に、2001年5月17日版から Text モジュールと名前を変えた。Text モジュールは2003年にいちど勧告候補となったが、その後ワーキング・ドラフトに戻ってそのままである。現在までに、Ruby モジュール、Text Decoration モジュールなどのほか、本モジュールを分割している。本モジュールは、当初は Text Layout モジュールと呼ばれたようであるが、変更の理由などはつまびらかにし得なかった。

“Styling vertical Chinese, Japanese, Korean and Mongolian text,” https://www.w3.org/International/articles/vertical-text/

これは、JIS X 4051:2004「日本語文書の組版方法」に、印刷媒体特有の箇所を改めはしつつも多くを拠っており、ばあいによっては原文書の不適切さも引き継いでいなくはない。

“Language matrix,” https://w3c.github.io/typography/gap-analysis/language-matrix.html

“Japanese Gap Analysis,” https://w3c.github.io/jlreq/gap-analysis/

「カクヨムでの縦組み表示の実装と、縦書き Web の将来に向けて」(builderscon tokyo 2018)- Hatena Developer Blog https://developer.hatenastaff.com/entry/2018/09/11/152905

《連載》「欧州・中東デジタル・ヒューマニティーズ動向」第19回

「Universal Dependencies: 依存文法ツリーバンクの世界標準」

Universal Dependencies(UD と略記、https://universaldependencies.org/[1])は、全ての言語のテクストの統語情報、語の情報をマークアップするために設定された枠組みである。統語論では、語同士の支配・依存関係を記述する依存文法(dependency grammar)と、語の集まりである句を設定し、語よりも上位の構造を考える構成文法(constituency grammar)の2種類の文法理論がメジャーである。特に後者の構成文法では、ノーム・チョムスキー(Noam Chomsky, 1928–)が始め、かつその発展を導いている、現在の理論言語学で最も重要な理論の一つである生成文法の研究が大変盛んである。それに対して、前者の依存文法は、ルシアン・テニエール(Lucien Tesnière, 1893–1954)によって隆盛したが、その後は、ワード・グラマーやリンク・グラマーなど、比較的著名になった文法理論が出たものの、現在は構成文法より研究が少ない。依存文法は、語同士の依存関係を記述していく文法であり、似た名称だが全く違った内容である文脈依存文法とは異なる。理論言語学の分野では、依存文法の研究は、生成文法などの構成文法の研究と比べて下火であると言わざるをえないが、今、コンピュータ言語学およびデジタル・ヒューマニティーズの世界では、依存文法を用いた Universal Dependencies という今回紹介する枠組みを用いた様々な言語のテクストのアノテーションが活発である。この UD の枠組みでは、UPOS という普遍的な品詞タグ、そして語同士の依存関係の普遍的なタグ付けによって、どの言語でも統語構造が記述されるため、諸言語の統語構造の比較が容易になる。UD は元々は、(Universal) Stanford Dependencies、Google Universal Part-of-Speech Tags、および、Interset の形態統語論タグセットの3つの枠組みを基に発展させたものである。世界各地で研究会などが開催されているが、日本でも国立国語研究所が2018年に UD の研究会、2019年に UD の国際シンポジウムを開催している[2]。

依存文法や構成文法で統語情報を記述すれば統語樹とよばれるツリー状の構造が得られるが、統語樹を集めたデータはツリーバンクと呼ばれる。構成文法で記述されたツリーバンクでは、Penn Treebank などが有名であり、これらのツリーバンクでは、クエリ言語を使って、語レベルだけでなく句レベルなど構成文法に特徴的な単位でも特定の統語構造を検索することができる。構成文法でのマークアップは、2語間の依存関係を記述していく依存文法よりも、句以上の単位で構造を記述し、どんどん上位構造を記述していかなければならず、作成に大変時間がかかる。それに対し、依存文法では、句以上の構造をマークアップする必要がないため、構成文法で書くよりもかなり短い時間でマークアップすることができる。

英語や中国語など、語順が比較的固定されている言語では、句構造のパターンが少ないが、チェコ語など語順が比較的自由な言語では、句構造の種類が莫大になるか、語の移動などを考慮しなければならなくなり、さらに記述の時間がかかる。その点、依存文法では、2語間の依存関係を記述してくのみであるから、語順が自由な言語でも、複雑な句構造を設定することなく、語順が固定された言語と同じくらいの労力で記述することが可能である。西洋古典の言語である古代ギリシア語とラテン語は語順が比較的自由である。これらの言語のテクストの統語情報を記述したツリーバンクは、Perseus[3]や PROIEL[4]のものが有名であるが、どちらも Universal Dependencies を用いて記述されている。

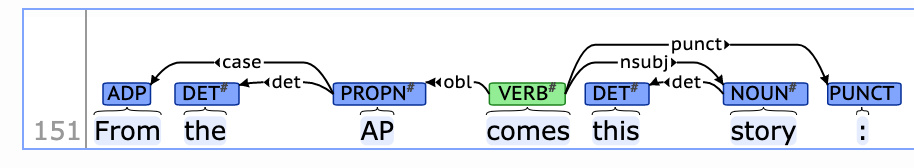

さて、Universal Dependencies の一例を見てみよう。図1は、英語の UD のツリーバンク English(UDx2.0)を SETS(http://bionlp-www.utu.fi/dep_search/)で表示し、動詞が名詞を支配している場合を検索したときの一例である。

動詞は comes で、後置された主語の名詞 story を支配しているが、その間の矢印には依存関係 nsubj が記されている。これは、動詞が主語名詞を支配していることを表している。このような支配・依存関係、そして依存の方向(右か左か)を加味して検索することも可能で、例えば、VERB >nsubj@R _ と検索すれば、右側に主語名詞を従えている動詞を含む文全てが表示される。

このように UD ツリーバンクを視覚化し、クエリ言語で検索できるようにするアプリとしては、フィンランドのトゥルク大学の SETS(http://bionlp-www.utu.fi/dep_search)の他にも、チェコのプラハ・カレル大学の PML Tree Query(http://lindat.mff.cuni.cz/services/pmltq/)、Kontext(http://lindat.mff.cuni.cz/services/kontext/corpora/corplist)、フランス・ナンシーのフランス国立情報学自動制御研究所(Inria)の Grew-match(http://match.grew.fr/)、ノルウェーのベルゲン大学の INESS(http://clarino.uib.no/iness)などがある。

現在、UD のデータベースには、2019年11月15日の時点で、90の言語の157のツリーバンクが公開されており、16の言語の UD が公開前である。ドイツ語が約375万語と、最も大きなコーパスであり、日本語も約168万語と大きい。これに対して、英語は約62万語と少ない。コミ語、グアラニー語、モクシャ語、サーミ語、ワルピリ語、ブリヤート語、ブルトン語などの少数言語、古代ギリシア語、ラテン語、ゴート語、コプト語など古典語も入っている。また、手話言語であるスウェーデン手話もある。

筆者の研究分野の言語は、コプト語、古代ギリシア語、ラテン語だが、古代ギリシア語には、PROIEL と Perseus の2つの UD ツリーバンクがある。総語数は、約41万語で、PROIEL のツリーバンクは約21万語、Perseus のツリーバンクは約20万語である。ラテン語 UDは総語数が約58万語で、内訳は、PROIEL の約20万語、ITTB[5]の約35万語、Perseusの約2万語である。

筆者が最も専門としているコプト語は約4万語である。これは筆者も research member として参加している、全米人文学基金(National Endowment for the Humanities)のコプト語電子コーパス・プロジェクトである Coptic SCRIPTORIUM(https://copticscriptorium.org/)のものである。ここでは、プロジェクト・リーダーの一人である Amir Zeldes の指揮のもと、現在、筆者も UD によるコプト語ツリーバンクの開発に携わっている。次回は UD のより詳細な構造とコプト語コーパスへの応用について論じる。

人文情報学イベント関連カレンダー

【2020年1月】

-

2020-01-17 (Fri)

シンポジウム「デジタル知識基盤におけるパブリックドメイン資料の利用条件をめぐって」於・東京都/都市センターホテル -

2020-01-25 (Sat)

第15回人間文化研究情報資源共有化研究会「人文系研究データの生成と管理ー「可逆性」の実現のために」於・東京都/日比谷図書文化館 スタジオプラス(小ホール) -

2020-01-25 (Sat)

Gale シンポジウム2020「デジタル人文学への誘い 第2回」於・大阪府/大阪府立国際会議場(グランキューブ大阪)12階 特別会議場http://gale.cengage.jp/content/news/「galeシンポジウム2020-「デジタル人文学への誘い-第2回/

【2020年2月】

-

2020-02-01 (Sat)

情報処理学会人文科学とコンピュータ研究会第122回研究発表会於・佐賀県/佐賀大学理工学部6号館 -

2020-02-15 (Sat)

第9回「知識・芸術・文化情報学研究会」於・大阪府/立命館大学 大阪梅田キャンパス -

2020-02-29 (Sat)

第25回公開シンポジウム「人文科学とデータベース」於・東京都/図書館流通センター(TRC)本社

Digital Humanities Events カレンダー共同編集人

イベントレポート「DADH2019学会参加報告書」

はじめに

2019年12月3日から12月6日にかけて、台湾師範大学で開催された「第十屆數位典藏與數位人文國際研討會(10th International Conference of Digital Archives and Digital Humanities)」(以下は DADH と略称)に参加した。この国際シンポジウムの規模は大きく分科会もあるため、本稿ではあくまでも参加したセッションの所見と筆者の発表内容について報告していきたい。

DADH は毎年12月ごろに台湾で開催されるシンポジウムであり、デジタル・ヒューマニティーズ全般に関しての様々な分野の発表者が集まっている。今回で10年目を迎えて、キーノートスピーチも含めて50件程の発表があった。台湾で開催される学会であるため中国語での発表が多いが、国際シンポジウムとして、英語での司会や一部には同時通訳も付いていた。

ワークショップ

まずは初日の事前ワークショップ、データベースや DH 研究プラットフォームについて報告する。そこでは「中央研究院數位人文研究平臺(Academia Sinica Digital Humanities Research Platform)」、「臺灣歷史人物傳記資料庫(Taiwan Biographical Database, TBDB)」、「通用型古籍數位人文研究平臺(Chinese Ancient Books Digital Humanities Research Platform, CABDHRP)」、「DocuSky: 個人學術研究的好幫手(DocuSky: Your Personal Research Partner)」の4つが提供された。

中央研究院數位人文研究平臺[1]は名前の通り、台湾中央研究院が開発した DH 研究プラットフォームである。文献のテキストをアップロードして、共同編集、内容検索、計量分析、可視化をすることができる。伝統的な文系研究者でも気軽にテキスト分析を試すことができる。

TBDB は台湾の歴史人名データベースであり、台湾師範大学によって開発公開されている。

CABDHRP は台湾国家図書館によって開発公開された中国古籍の研究プラットフォームであり、台湾国家図書館で公開された一部の古典籍を導入して分析することができる。

DocuSky は台湾大学が開発した研究プラットフォームである。機能上では先述の中央研究院數位人文研究平臺と似ている部分もあるが[2]、英語インターフェースの公開が予定されている。

プログラム

今回のシンポジウムでは、4日から6日にかけて、キーノートスピーチ3件、パネル15件、ポスター11件、口頭28件の発表が行われた[3]。口頭発表はテキスト分析、DH の基盤建設とツール(1)、DH と歴史、DH の基盤建設とツール(2)、DH の進化と教育、DH と時空、可視化とソーシャルネットワーク分析、DH の経験と反省の8つのセッションに分けられていた。プログラムは次のリンクから参照できる。

https://dadh2019.conf.tw/site/page.aspx?pid=305&sid=1308&lang=en

興味深い発表

特に興味深い発表を挙げるとするなら、まずは京都大学人文科学研究所の安岡孝一先生の “Universal Dependencies Treebank of the Four Books in Classical Chinese” である。中国古典の四書を用いて、UD(Universal Dependencies)によって漢文の解析を行った。現代中国語の自動解析は深く研究さており、検索エンジンや音声入力などのように、一般の生活に浸透しているが、ほぼ死語とも言える古典中国語の自動解析に関する研究はまだまだこれからであることが分かった。

もう一件は台湾大学法学部の学生である康心宥・郭恩佳が発表した「車禍案件中法院判定過失比例之因素分析」(交通事故における裁判所が判決した過失割合のファクター分析)である。タイトルの通り、実際に判決が下された交通事故中の車速、車種、怪我の程度などを因子にして、Rを用いてファクター分析を行った。その結果を利用して、裁判所が下した交通事故の過失割合を予測することができる[4]。

安岡先生以外にも日本の研究者による発表があった。大阪大学の田畑智司先生はキーノートスピーチ “Digital Humanities as Non-Linear Reading: Style in Classic British Fiction”、東京大学の高木聡一郎先生はキーノートスピーチ “Innovation Capability: Implications from Social and Economic Transformation Driven by Blockchain Technologies”、上智大学の Gramlich-Oka Bettina 先生は口頭発表 “Japan Biographical Database” を行った。

日本と対比して

日本の DH 系学会に比べると、文献の導入から分析の結果まで一連のプロセスを一つのアプリケーションで行う研究プラットフォームについての発表が多いと感じた。また、分析対象として法律や政治を扱う研究も多く、社会的課題との関連性が深い。

日本で近年よく扱われる IIIF と LOD は、今年の DADH ではあまり見られなかった。当然のことであるが、各地域の研究環境と注目点の差異も強く感じた。TEI に関する発表は1件のみだったが、テキストマークアップの発表は複数あり、自動的なマークアップをテーマとするパネルまで設けられていた。

報告者の発表

筆者も今回の DADH で発表させていただいた。題目は「宋本《玉篇》圖形資料庫之構建(A Graph Database of Chinese Dictionary Da Guang Yi Hui Yu Pian)」であり、中国語と日本語の研究における重要な古辞書、『宋本玉篇』のグラフデータベースを構築する取り組みについて発表した。

古辞書には多くの漢字情報が記載され、研究の進展により、該当古辞書のデータベースに格納するスキーマの更新やリレーションシップの増加は頻繁に生じる。特に注釈テキストにおけるマークアップされた情報の検索・整理に対して、現在利用している関係データベースで対応することは難しくなってきた。そこで、報告者は HDIC で公開している「宋本玉篇テキストデータベース」を用い、掲出字の注釈から異体字・同義字・同音字を抽出して、これらの情報とリレーションシップを Neo4j に格納して、古辞書のグラフデータベースを作成した。以上が、報告者の発表の概要である。

来年の DADH2020は、台北にある台湾中央研究院にて開催される予定である。興味ある方は是非ご参加していただきたい。

◆編集後記

今回は、くずし字自動認識で活躍しておられるカラーヌワット・タリン先生より巻頭言をいただきました。元々お持ちだった二つの深いご関心があのようにして昇華していく様は、時代がついてきた、という表現がまさにふさわしいものでしょう。これからさらにどんな世界を見せてくださるのか、期待しつつ、応援していきたいところです。(永崎研宣)

- コメントを投稿するにはログインしてください