人文情報学月報第167号【後編】

ISSN 2189-1621 / 2011年08月27日創刊

目次

【前編】

- 《巻頭言》「デジタル人文学、オープンサイエンス、研究データ管理:ドイツの計算文学研究における交点を探る」

:トリーア大学 - 《連載》「欧州・中東デジタル・ヒューマニティーズ動向」第83回

「ドイツ Exzellenzstrategie におけるデジタル・ヒューマニティーズの展開:2007–2025年の軌跡と第2期採択結果の分析」

:筑波大学人文社会系

【後編】

- 《連載》「英米文学と DH」第6回

「データカプセル上の分析」

:中央大学国際情報学部 - 人文情報学イベント関連カレンダー

- イベントレポート「DH 国際シンポジウム「デジタル画像とテキストの新展開:自動文字読み取りの最新動向とその利活用」参加録」

:慶應義塾大学文学部 - 編集後記

《連載》「英米文学と DH」第6回

「データカプセル上の分析」

データの取り込みと出力

前回までの連載で、ハティトラスト・リサーチセンター(以下 HTRC)のデータカプセルの概要、システム構成、書籍データの入手方法について示した[1]。ここまでの話で、読者がデータカプセルにアクセスし、分析したい書籍データを揃えることができたわけである。今回は用意した書籍データを分析するやり方について主に述べたい。はじめに、データ全般の取り込みと出力の仕組みについて理解した後、利用できる分析用ソフトウェアを紹介する。最後に共同利用のやり方についても触れる。

データカプセルへのデータ全般の取り込みについては制限はない。従って、分析したいデータを持ち寄り、グーグルドライブ等のクラウドサービスやメールなどを介して、書籍データや一般のデータをデータカプセルに取り込むことができる[2]。

一方で、データカプセルから外部へのデータの出力は大きな制約がある。著作権に配慮した非消費利用型研究ポリシーに基づき、書籍データの OCR テキストや画像、バイナリファイル、暗号化されたファイル、1MB を超える大きさのデータは出力できない。これらはすべて申請後人の目で確認される[2]。従ってかなりの期間待たされることもあるため注意が必要である。

分析結果などのデータの外部出力を行うには、セキュアモードに切り替えた後、releaseresults という独自のコマンドを使用する[3]。add および done というオプションがあり、外部出力を申請するファイルをaddオプションで専用のディレクトリに保存し、doneオプションで申請を行う。例えば、graph_a.svg および graph_b.svg という分析結果のファイルを出力したいとする。端末(ターミナル)を開き、該当のディレクトリに移動したうえで、

releaseresults add graph_b.svg

と入力する。最後に、

releaseresults done

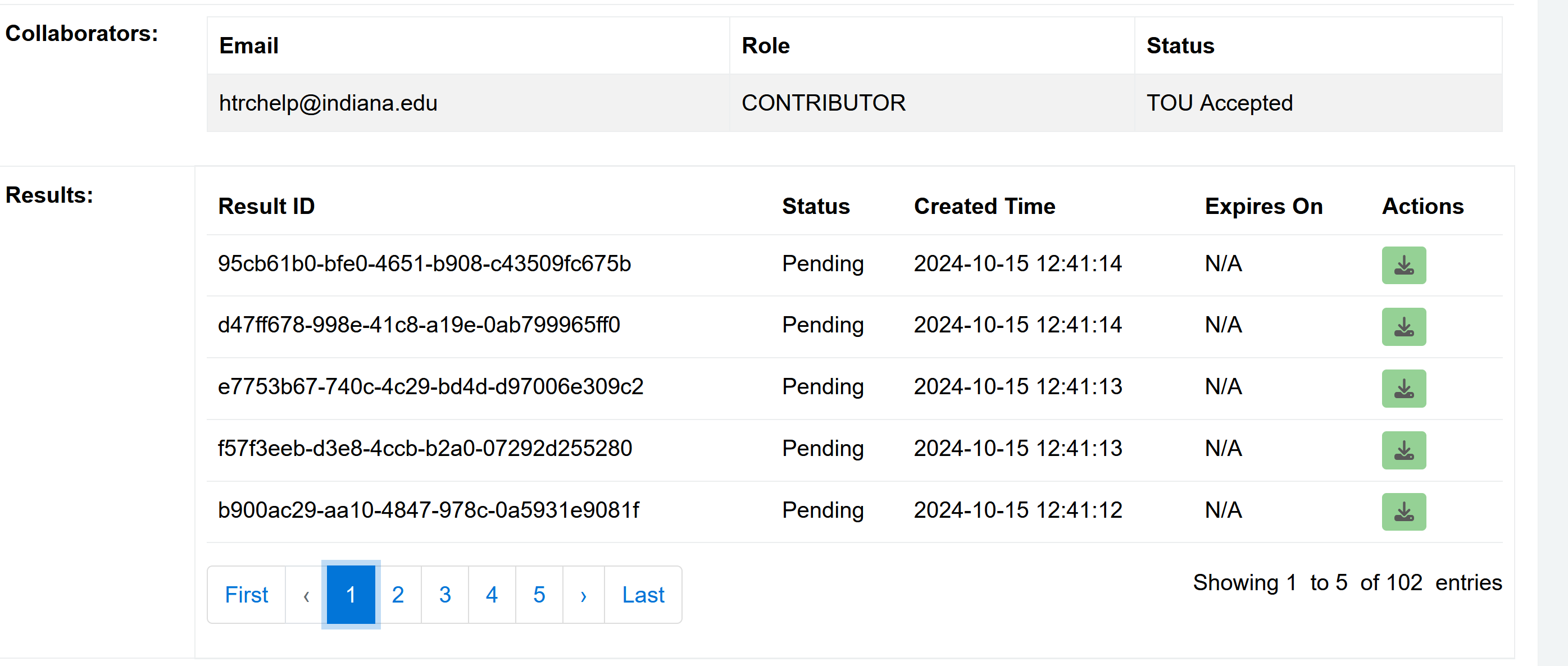

と入力して送信すれば、外部出力の申請となる。なおよくエラーが出るので、その場合は一度サーバーを再起動するとよい。HTRC の研究者による確認が行われた後、出力が認められれば、HTRC のウェブサイトの自分のプロジェクトのページの結果の欄にダウンロード可能な結果が掲載される(図1)。許可された場合、アクション欄のボタンを押してダウンロードできる。

利用できる分析用ソフトウェア

データカプセルにはあらかじめ種々のソフトウェアやライブラリが用意されている。代表的なものをあげれば表1のようになる[4]。

| 表1: データカプセルに付属のソフトウェア・ライブラリなど。 [4]を参考に筆者作成 |

|---|

| Software Anaconda Mallet R Voyant Tools Python libraries htrc-feature-reader htrc workset toolkit GenSim nltk numpy pandas scipy |

このうち、アナコンダ(Anaconda)とマレット(Mallet)について紹介する。

アナコンダはデータサイエンスや機械学習のためのプラットフォームであり、Python によるプログラム作成などを行うことができる[5]。Pythonを使うには、アナコンダの中のジュピターノートブックというソフトウェアを使うことが多いだろう。例えば、1740年から1840年に出版されたハティトラストに所収の書籍データの数量をグラフにしたいとする。ここで一つ注意する点は、インターネットが使えるのはメンテナンスモードのみであり、またハティトラストの書籍データを扱えるのはセキュアモードのみであるということである。生成AIでプログラムを作成させる場合など、インターネットを使う場合は都度メンテナンスモードに戻る必要がある。

まず、メンテナンスモードで端末を開き、以前の連載で紹介した詩のメタデータを以下のコマンドでダウンロードする[6]。

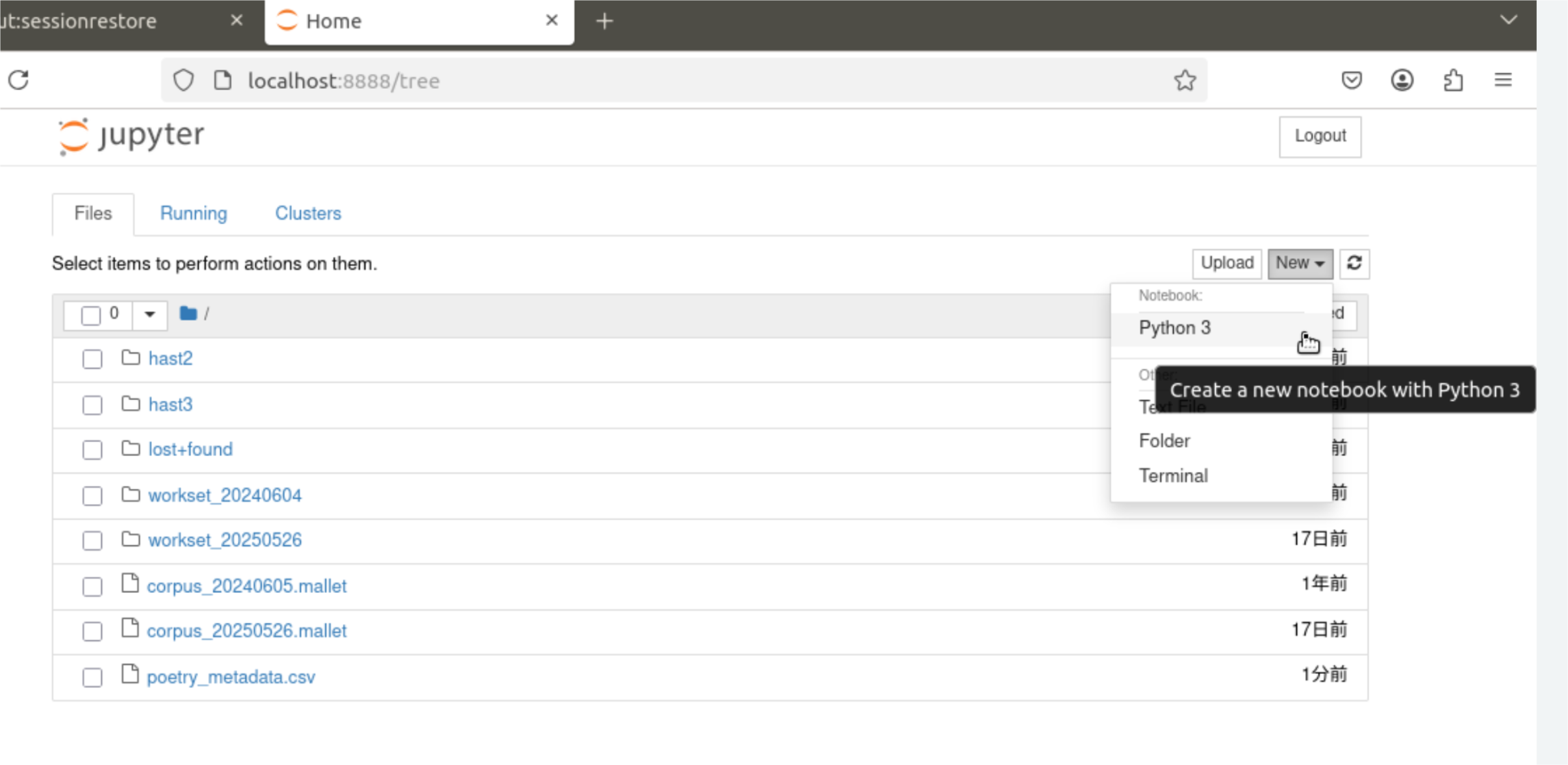

次に、セキュアモードに移動し、ダウンロードしたメタデータをセキュアモード専用のフォルダに移す。その後アナコンダに付属の Python 作成ツールであるジュピターノートブックをコマンドから開く。

cp ~/poetry_metadata.csv

jupyter notebook

最初の画面で、図2のようにジュピターノートブックを新規作成する。

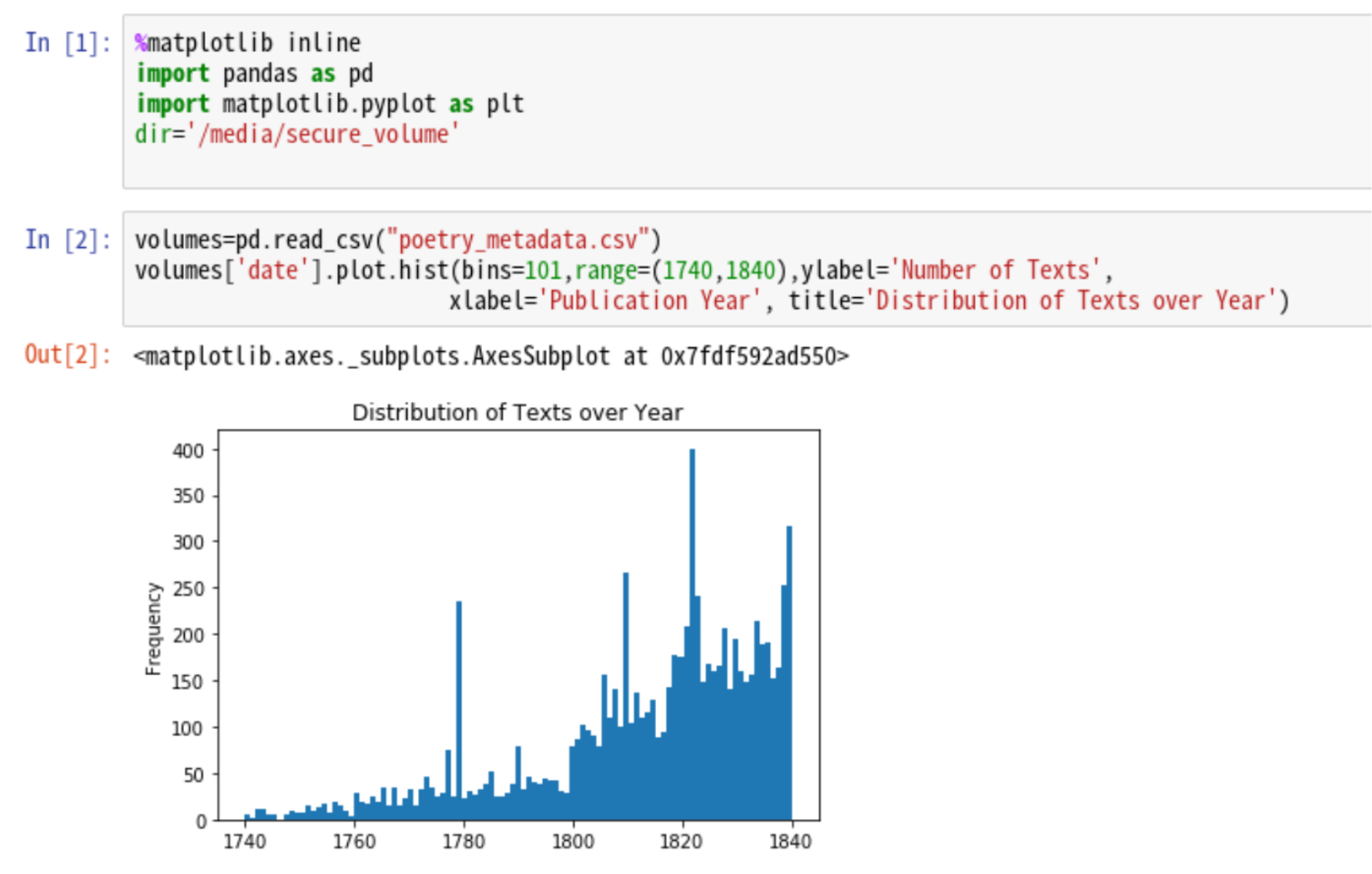

次に、ジュピターノートブックの画面で、次のようにメタデータを読み込んでヒストグラムを描画するプログラムを作成する。

import pandas as pd

import matplotlib.pyplot as plt

dir='/media/secure_volume/'

volumes = pd.read_csv(dir+'poetry_metadata.csv')

volumes['date'].plot.hist(bins=101,range=(1740,1840), ylabel='Number of Texts', xlabel='Publication Year', title='Distribution of Texts over Year')

実行させると、図3のような結果が出る。1740年から1840年の所蔵書籍データの数量を表すヒストグラムである。

次にマレットの利用方法を紹介する。マレットはトピックモデリングの分析を行うソフトウェアである[7]。トピックモデリングは共起する語句ごとに重みを与える分類を行う。マレットは端末上でシェルコマンドを入力して操作する。初めに一回だけ、マレットの使用メモリを調整する必要がある。以下のようにシェルのエディタを利用して使用メモリの量を書き換える。

iキーを押して編集可能モードにしたのち、MEMORY=1g の行の1g を12g など上限に近いメモリ量に変更し、エスケープキー、:wq!と順に押して保存して戻る。

さてマレットの実行は、事前準備と分析実行の二段階に分かれる。初めにテキストの書籍データを読み込み、マレット専用の実行ファイルを作る事前準備を行なう。以下のように書籍データを読み込んだディレクトリと、必要なオプションを指定して、htrc run mallet コマンドを実行して事前準備を行う。

書籍データの量にもよるが、数時間から一日以上かかることもある。ブラウザを修了させ PC をシャットダウンして待っていてよい。HTRC のウェブサイトからデータカプセルを開くと、リモートの接続先のデータカプセルは処理を実行し続けていることがわかる。事前準備が終了したら、以下を参考にコマンドを実行して分析実行を行う。オプションの詳細はウェブサイトおよびマレットのヘルプファイルにある[8]。同様に長い時間がかかる点に注意である。

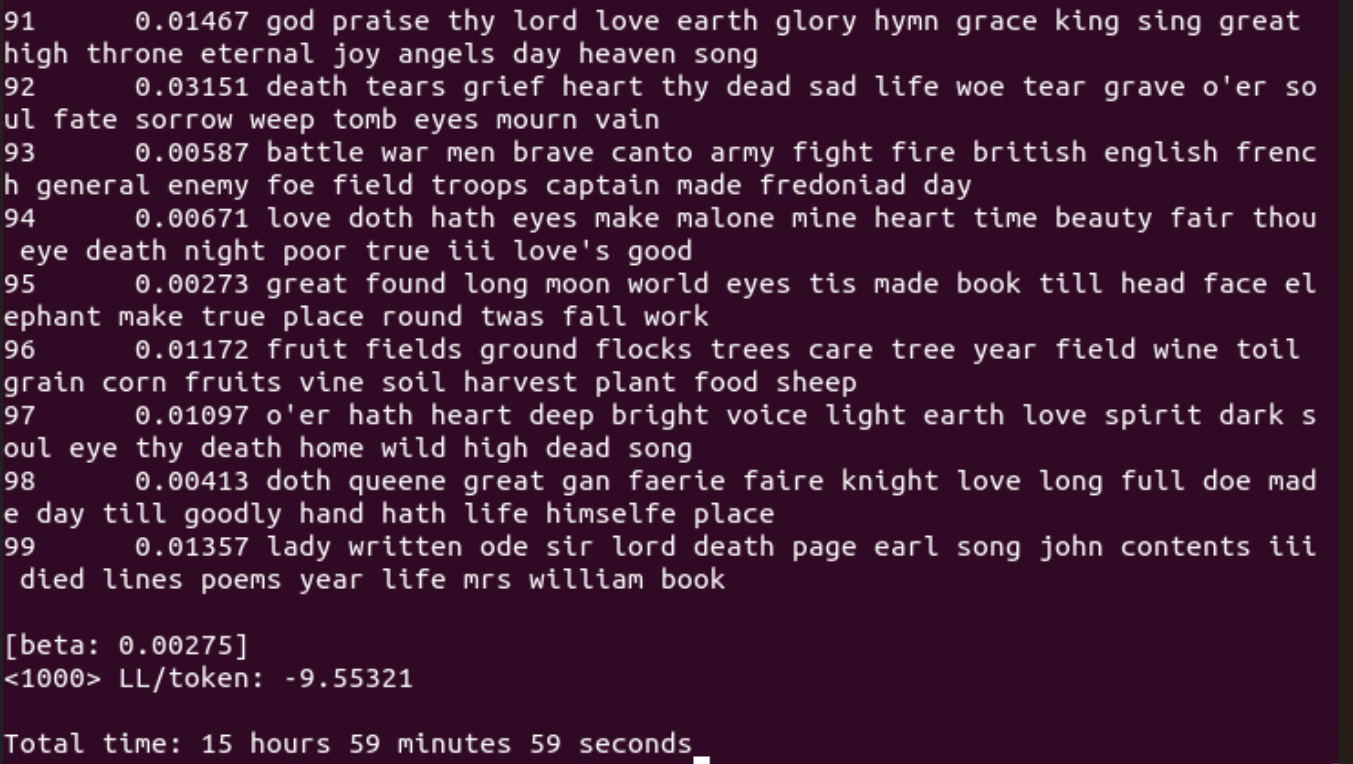

分析が終わったら、トピックごとの上位語句のリストやファイルごとのトピックの分布を利用して書籍データの分類の分析を行うことができる(図4)。トピックごとに、共起する語句のうち重みの大きい語句を調べて、人間がトピックにラベル付けをする。様々な角度からトピックを調べると分析の結果を得やすい。

共同利用の方法

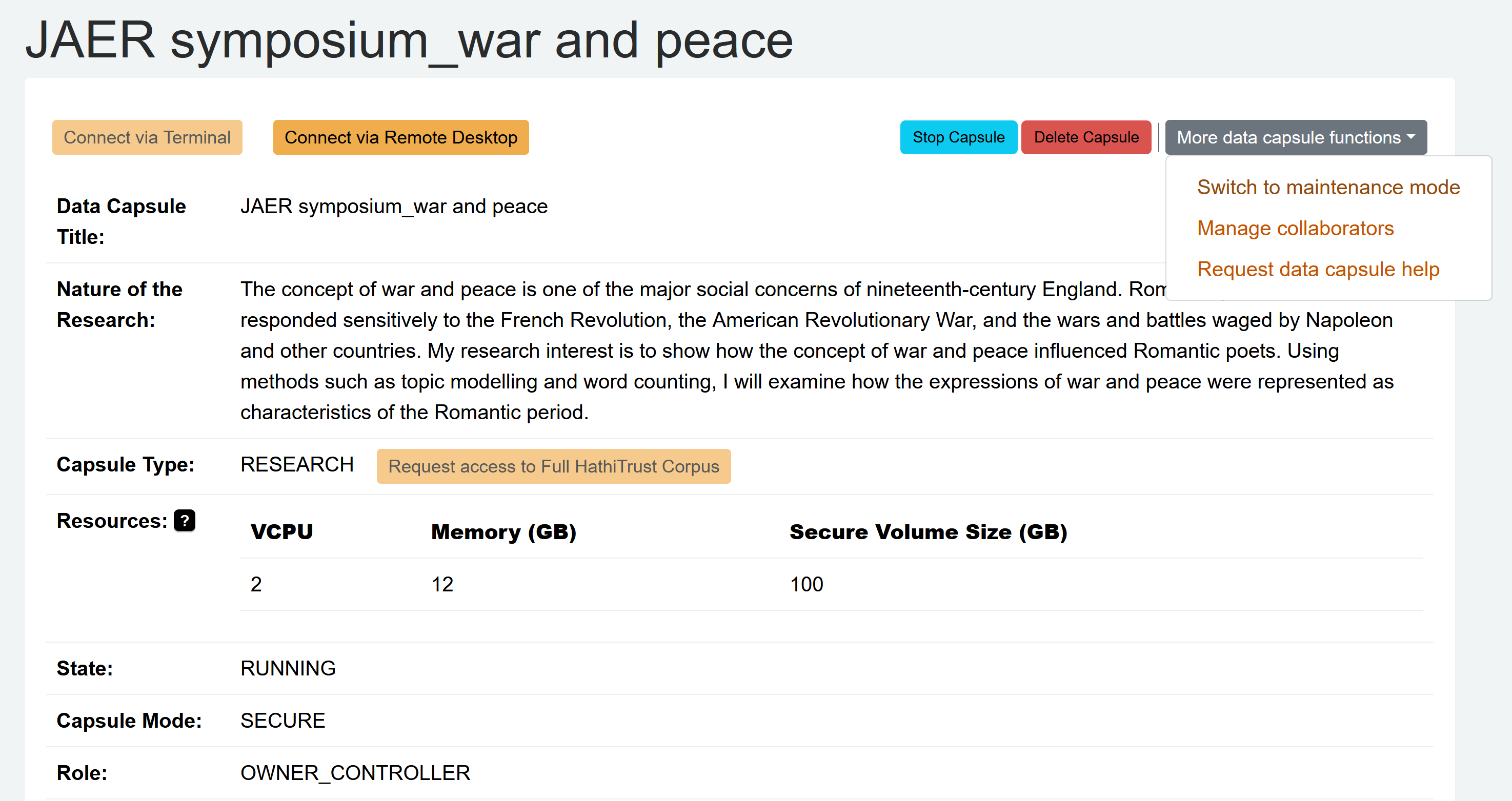

データカプセルのプロジェクトは5人まで利用者を追加し共同で一つのプロジェクトを操作できる[9]。共同利用者を追加するには、プロジェクトのページで More data capsule functions のボタンを押し、Manage collaborators を選択するとよい(図5)。HTRCに登録している他の共同利用者のメールアドレスを入力して追加できる。承認後、他の共同利用者の役割を変更できる。詳細は HTRC のドキュメントを参照されたい[10]。

今回までの連載で、ハティトラスト・デジタルライブラリー、HTRC、データカプセル、データカプセルを用いた書籍データの入手と分析について紹介した。原稿執筆時点で、2026年12月末まで利用することが可能である。読者は大量の書籍データを用いた遠読などの分析を試されるとよいだろう。書籍データおよび分析環境を提供していただいているハティトラストおよび HTRC に深く感謝したい。

人文情報学イベント関連カレンダー

【2025年7月】

-

2025-7-1 (Tue), 10 (Thu), 15 (Tue), 24 (Thu), 29 (Tue)

TEI 研究会於・オンライン -

2025-7-7 (Mon)

第24回 CODH セミナー「カメラアプリ「メモリーグラフ」によるフィールドワークの展開:地域文化資源、観光、防災、人文学研究への利用事例」https://codh.rois.ac.jp/seminar/memorygraph-20250707/

於・国立情報学研究所およびオンライン -

2025-7-14 (Mon) ~ 2025-7-18 (Fri)

DH2025: Accessibility & Citizenship於・Universidade NOVA de Lisboa -

2025-7-20 (Sun) ~ 2025-7-22 (Tue)

DHEAC: Annual International conference on digital humanities for East Asia Classics於・Beijing Library

【2025年8月】

-

2025-8-3 (Sun)

第139回人文科学とコンピュータ研究発表会https://www.ipsj.or.jp/kenkyukai/event/ch139.html

於・シャトレーゼホテル談露館 -

2025-8-7 (Thu), 12 (Tue), 21 (Thu), 26 (Tue)

TEI 研究会於・オンライン

【2025年9月】

-

2025-9-4 (Thu), 9 (Tue), 18 (Thu), 23 (Tue)

TEI 研究会於・オンライン -

2025-9-16 (Tue) ~ 2025-9-20 (Sat)

TEI 2025https://tei2025.confer.uj.edu.pl/en_GB/

於・Jagiellonian University -

2025-9-19 (Fri) ~ 2025-9-21 (Sun)

JADH 2025https://jadh2025.hmt.osaka-u.ac.jp/

於・大阪大学

Digital Humanities Events カレンダー共同編集人

イベントレポート「DH 国際シンポジウム「デジタル画像とテキストの新展開:自動文字読み取りの最新動向とその利活用」参加録」

2025年6月3日、慶應義塾大学三田キャンパスにおいて DH 国際シンポジウム「デジタル画像とテキストの新展開: 自動文字読み取りの最新動向とその利活用」が開催された[1]。文部科学省人文学・社会科学のDX化に向けた研究開発推進事業・研究基盤ハブ(受託機関・慶應義塾ミュージアム・コモンズ)の主催で、共催として科研費特別推進研究「デジタル研究基盤としての令和大蔵経の編纂―次世代人文学の研究基盤構築モデルの提示(JP25H00001)」・科研費基盤研究(B)「人文学の研究方法論に基づく日本の歴史的テキストのためのデータ構造化手法の開発(JP23K28385)」が加わっている。なお、今回の参加録で大きな問題になるとは思っていないが、筆者は主催の研究基盤ハブに一員として加わっているほか、シンポジウムの総合司会も務めたため第三者として客観的な叙述には徹しきれないかもしれないことをお断りしておく。

今回のシンポジウムは、開催趣旨によれば、「フランス発のオープンソースの手書き文字認識プラットフォームプロジェクト eScriptorium の共同代表、Peter Stokes 教授と、国立国会図書館で古典籍 OCR の開発を推進する青池亨氏」とを迎えて開かれたものとのことであり、両氏の講演のほか、Stokes 氏の所属する PSL 大学関係者、そしてホスト側の関係者から発題があった。

冒頭は主催者から永崎研宣氏が「OCR の高度化とそれを利用した古典籍画像活用の可能性」と題されて趣旨説明と現状の見取り図の報告がなされた。また、氏の長年携わってこられた SAT 大蔵経プロジェクトにおける校勘事業——そこで OCR の活用をしていることが本シンポジウムの背景にあると言ってよい——の紹介があった。

つづいて、Peter Stokes 氏の講演が行われた。Peter Stokes 氏は、現在フランスの高等研究実習院(PSL 研究大学の一角をなす)の「西欧古代の文字・表記に対するデジタル・計算人文学応用」研究教授であり[2]、デジタル人文学を応用した古書体学(palaeography)・書物学(codicology)[3]の専門家である。eScriptorium[4]は、PSL 研究大学のプロジェクトである Scripta プロジェクトのデジタル人文学部門である eScripta チーム[5]が主導する、印刷資料および手書き資料の自動テキスト認識(Automatic Text Recognition: ATR)[6]をするためのプラットフォームであって、Stokes 氏はその共同代表である。

今回の講演では、氏が最近取り組んでおられる、多文字体系写本自動テキスト認識(multi-script automatic recognition)を中心に話が進められた[7]。eScriptorium では、当初より多言語・多文字体系対応を目指していたとのことで、そのためのATRエンジンkraken[8]の開発にも取り組まれてきた。講演では、多言語・多文字体系対応のシステムが抱える困難——Unicode 符号化の対応度、文字方向や表記形式の複雑さ、生成 AI の学習源とするには「学習データ」が不足していることなど——が具体的に紹介された。また、ATR からテキスト研究に向かうことの困難が指摘され、そのほかの活用法として、レイアウト分析や文字体系と言語との関係、テキストの同定、テキストと画像の対応付け、書き込みの検知などが挙げられた。レイアウト分析の実例として、ひとつの資料体のページ数が多くなるほど、行間注などの書き込みの粗密のばらつきが増えるということが示された。また、古書体学の研究にも有効に用いることができることが示されたが、最後に提起された「「a」という文字はなにによって「a」という文字たりうるのか」という知識モデルへの問いは似たような関心を持つ者として大いに触発された[9]。

そののちは、PSL 大学で Stokes 氏と協力関係にある面々からそれぞれの取組みについて短い発表がされた。Daniel Stockholm 氏は、”AI and Computer Vision Approaches to the Study of Animals in Medieval Illuminated Manuscripts(中世装飾写本に描かれた動物の研究へのAIおよびコンピュータビジョンの応用)”と題して中世装飾写本に描かれた動物についてのオントロジなどの紹介がされた[10]。ついで、Chahan Vidal-Gorène 氏からは、”Manuscript restoration using Generative networks(生成ネットワークを用いた写本の修復)”と題して、写本の欠損部分を生成AIで修復できないかというこころみが紹介され[11]、遠目にはそれっぽく見えることに驚かされた。Florian Cafiero氏からは、”Augmented Diplomacy: Transcription, Semantic Edition, and AI-Assisted Exploration of the Archives of Multilateralism(AI を活用した外交史料研究:多国間主義アーカイブの転写、意味的校訂、AI 支援による探索”と題して、外交史料に対する生成AIやオントロジ[12]の紹介と活用について述べられた。

つぎの部では、青池氏からの講演と、慶應義塾大学の安形麻理氏から日本の研究状況の紹介が行われた。青池亨氏は、国立国会図書館の司書であるが、次世代システム開発研究室において、同館のさまざまな新システムの開発に取り組まれておられ、とりわけ OCR 関係で大きな寄与をされてきたことは、すでに本月報でも紹介したことがあるし、ご本人によって本月報に巻頭言も寄せられているところである[13]。本シンポジウムとしては、Stokes 氏をふくめた聴衆への紹介という面が大きかったが、国立国会図書館内部の OCR システムと eScriptorium のシステム構成とが類似しており、容易に協力できそうであるとの指摘は興味深かった。

安形氏からは、安形輝氏との共同研究として、氏が長年取り組まれてきたグーテンベルク四十二行聖書活字の文字データセット抽出が紹介された[14]。グーテンベルク四十二行聖書活字をめぐっては、従来説を疑問視する研究結果が提出されてその後はかばかしい進展がなかったものが、両氏の検討では、さまざまな修正の余地があるという。着実な用例蒐集がものをいうということを実感させられた。

最後の討論では、分類の問題やAIと教育の問題などが話題となっていた。

全体として、分け入るということが知への冀求であるということをあらためて強く感じさせられたと同時に、いかに規模を大きくしていくかのトレードオフも問題になったと思う。多くの聴衆にとっては、ややこしさに恐れ入って終わってしまったかもしれないが、コンピュータを使って根本的な研究をしたいと願うとはこういうことだというものでなかっただろうか。

– IDIOM: A Digital Research Environment for the Documentation and Study of Maya Hieroglyphic Texts and Language | Writing from Invention to Decipherment | Oxford Academic https://academic.oup.com/book/58672/chapter/485388730.

– POGO: Philology-Oriented Graphematics Ontology https://zenodo.org/records/10355606.

– Four-Layer Grapheme Model for Computational Paleography: Computer Science & IT Journal Article | IGI Global Scientific Publishing https://www.igi-global.com/article/four-layer-grapheme-model-for-computational-paleography/172092.

– Types of allography https://www.degruyterbrill.com/document/doi/10.1515/opli-2020-0006/html.

– kcl-ddh/digipal: Digital Resource for and Database of Paleography, Manuscripts and Diplomatic https://github.com/kcl-ddh/digipal.

◆編集後記

数日前に Google が Gemini CLI をリリースし、1日に1000回まで無料で、その最新版である Gemini 2.5 pro をコマンドプロンプトのような形で様々に利用できるようになりました。パソコンの中のファイルを必要に応じて指定してそのままアップロードし、ファイルの作成もしてくれるようになり、これをそれほどの回数利用できるようになったことで、生成 AI の利用の仕方がいよいよ次の段階に発展していきそうです。もちろん、ハルシネーションがなくなるわけではなく、筆者が試した限りでも、内容によっては、聞いてないことや頼んでないことを次々に繰り出してくるようになり、1日1000回の利用枠といってもかなりの時間を訂正させることに費やされる感じになっていますので、相変わらずすべてを委ねられるというわけではなさそうです。しかしながら、たとえば筆者が最近寄贈していただいた10冊ほどの本が並んだ書棚を撮影した画像から背表紙に書いてあることをすべて文字起こしをさせた際には、様々な言語の本であるにも関わらず、飾り文字も含めて正確に実行できました。一部の本は敢えて天地逆にしてみましたが、それも含めても正確に読めてしまいました。もちろん、Google が Google Books というコンテンツを抱えていることを考えると、最近の本の読み取りに強いであろうことは容易に想像できるところです。古典籍の木版や写本の字や古文書の手書きの文字にどれくらい対応できるかを確認するのはこれからですが、これももしかしたら使い方次第では相当な精度が出る可能性もあります。

もちろん、生成 AI の課題は、文字起こしのみではなく、むしろ、そのようにして得られたテキストから何を生み出せるのか、そしてそれによって何を社会にもたらすことができるのか、というところが重要です。とりあえず研究に役立てられるという意味では、今月の13日に慶應義塾大学三田キャンパスで開催された Sebastian Nehrdich 氏を講師とした DH 国際ワークショップでは、大規模言語モデルを仏教研究の様々な場面で役立てられるツールの紹介が行なわれました。告知がかなり直前だったにもかかわらず参加申込みが110名を超えたところからもその期待度は想定されるところでしたが、実際のところ参加者の方々からは大変な好評を博しました。

今後も着々と生成 AI が進歩していくなかで、どこまでは生成 AI を利用し、どこからは人が判断するのか、という線引きは少しずつ変化していくことでしょう。その見極めをきちんと行い、人が判断すべきところを明白にし続けていくこともまた、これからの人文学の重要な役割の一つとなっていくことでしょう。

- コメントを投稿するにはログインしてください